Single exposure light field imaging based all-in-focus image reconstruction technology

-

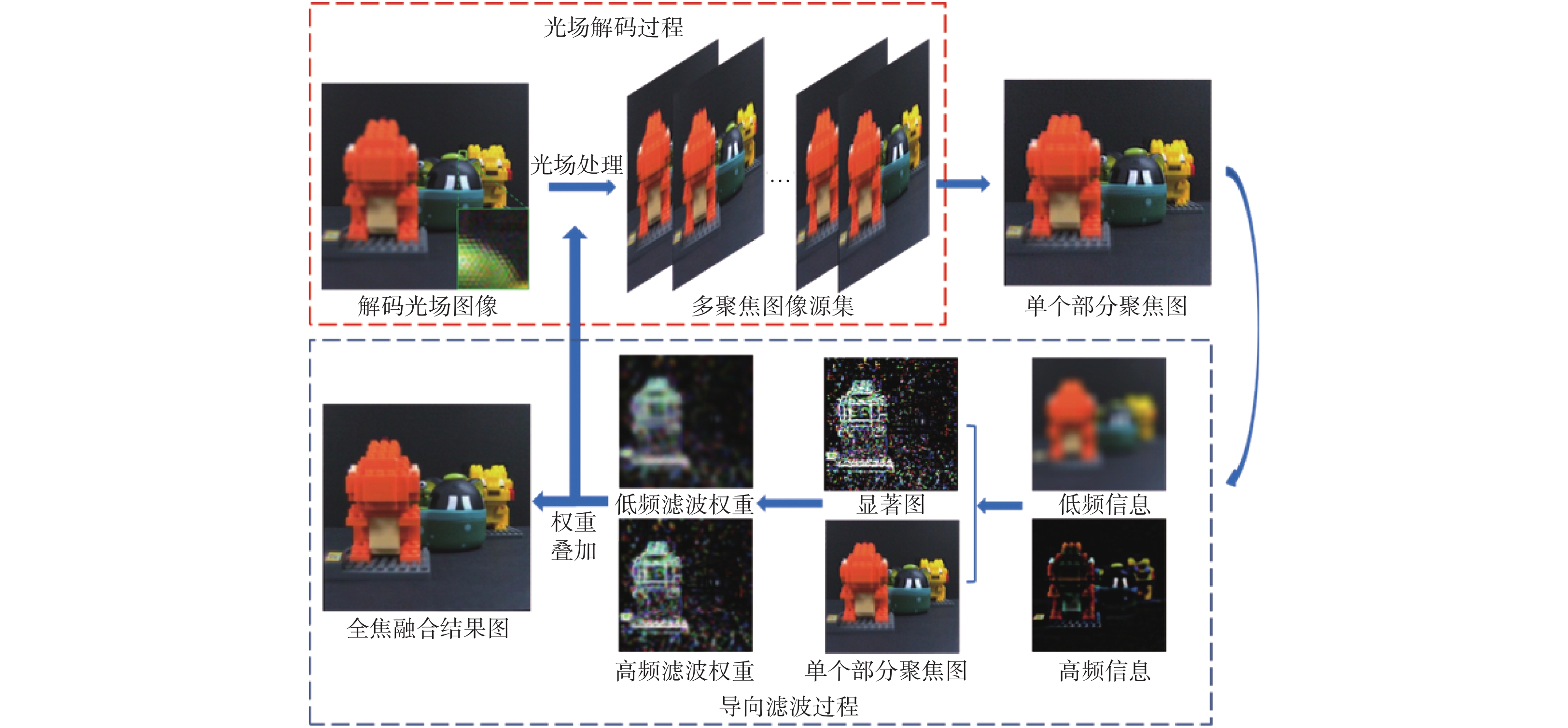

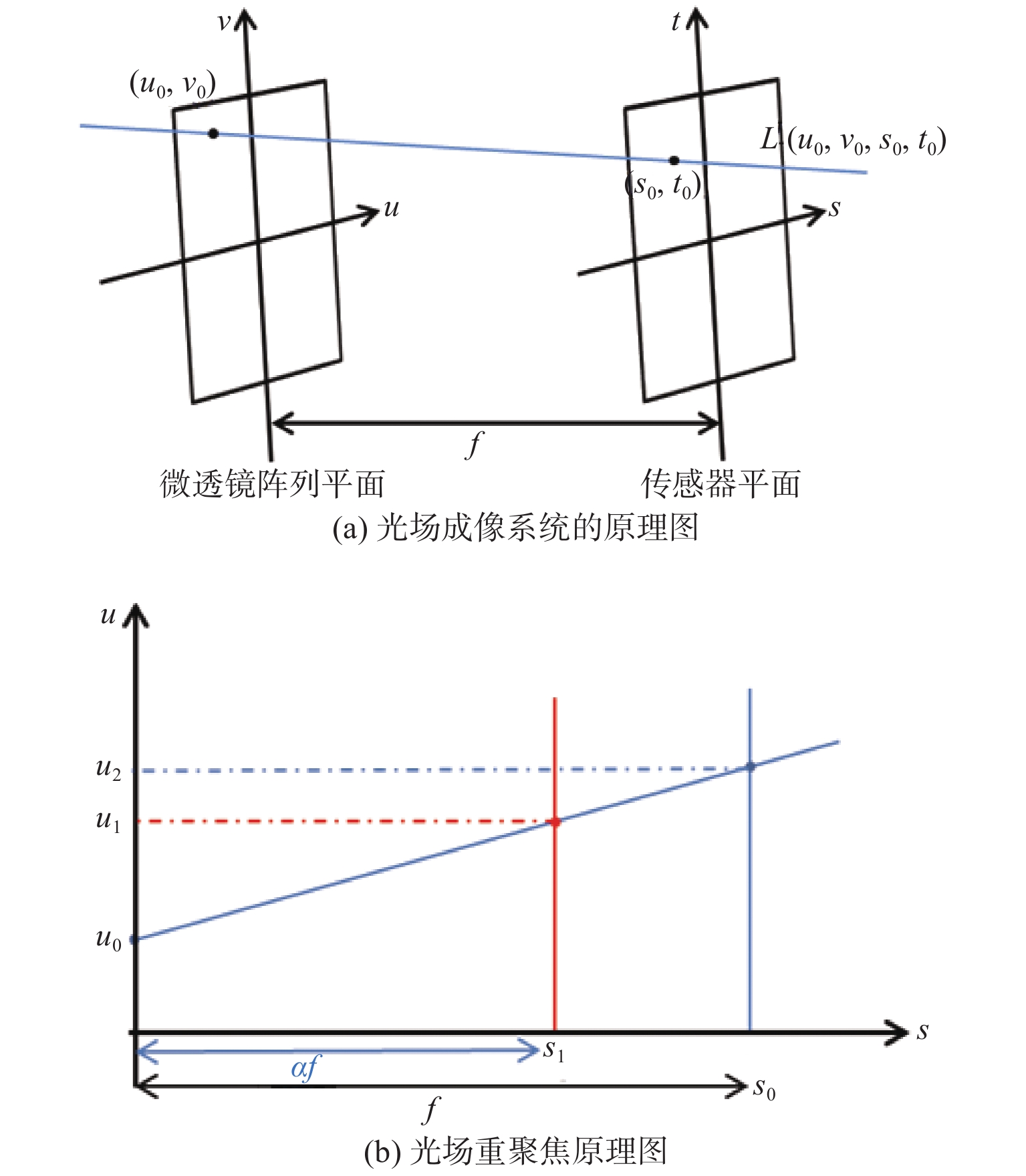

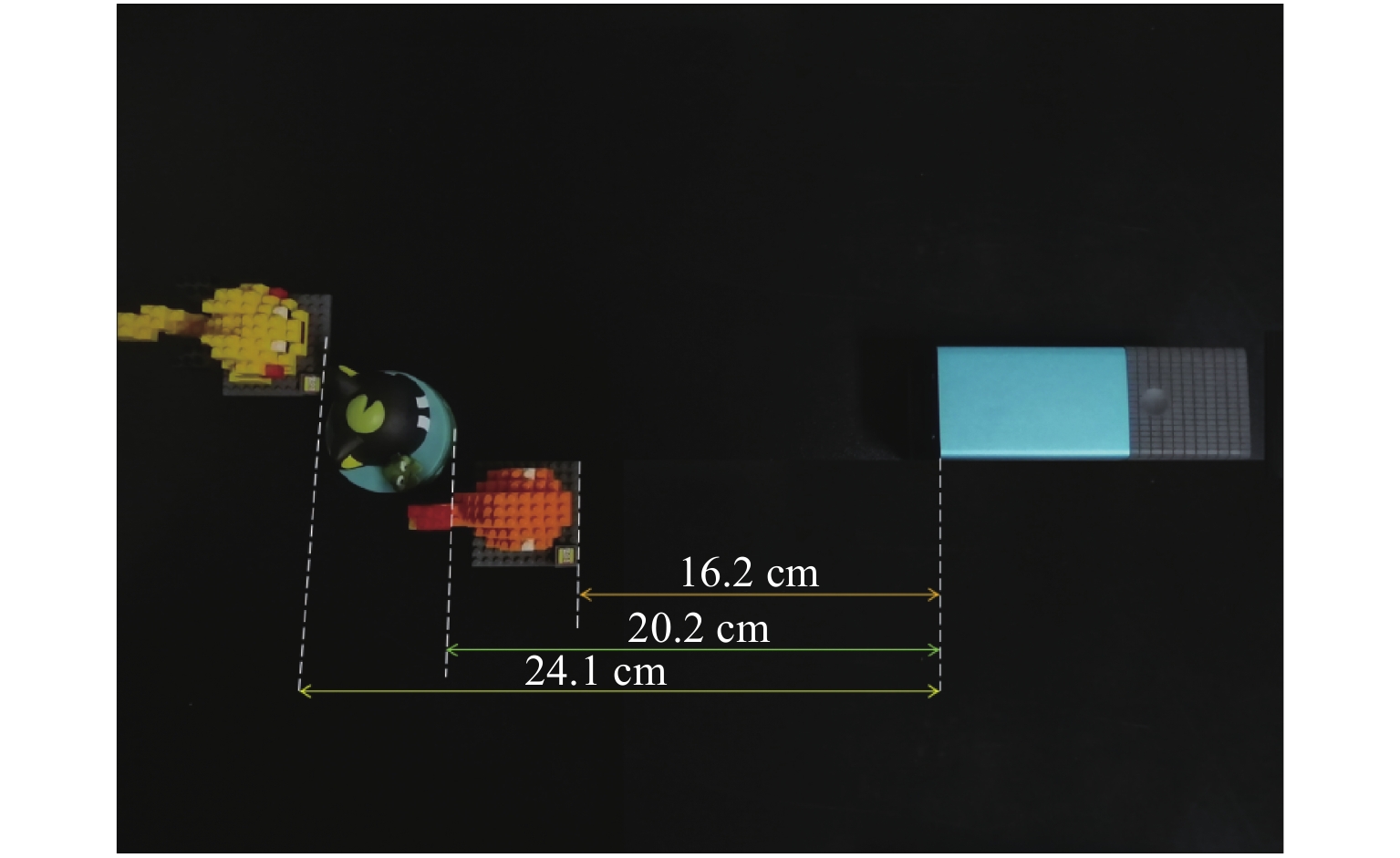

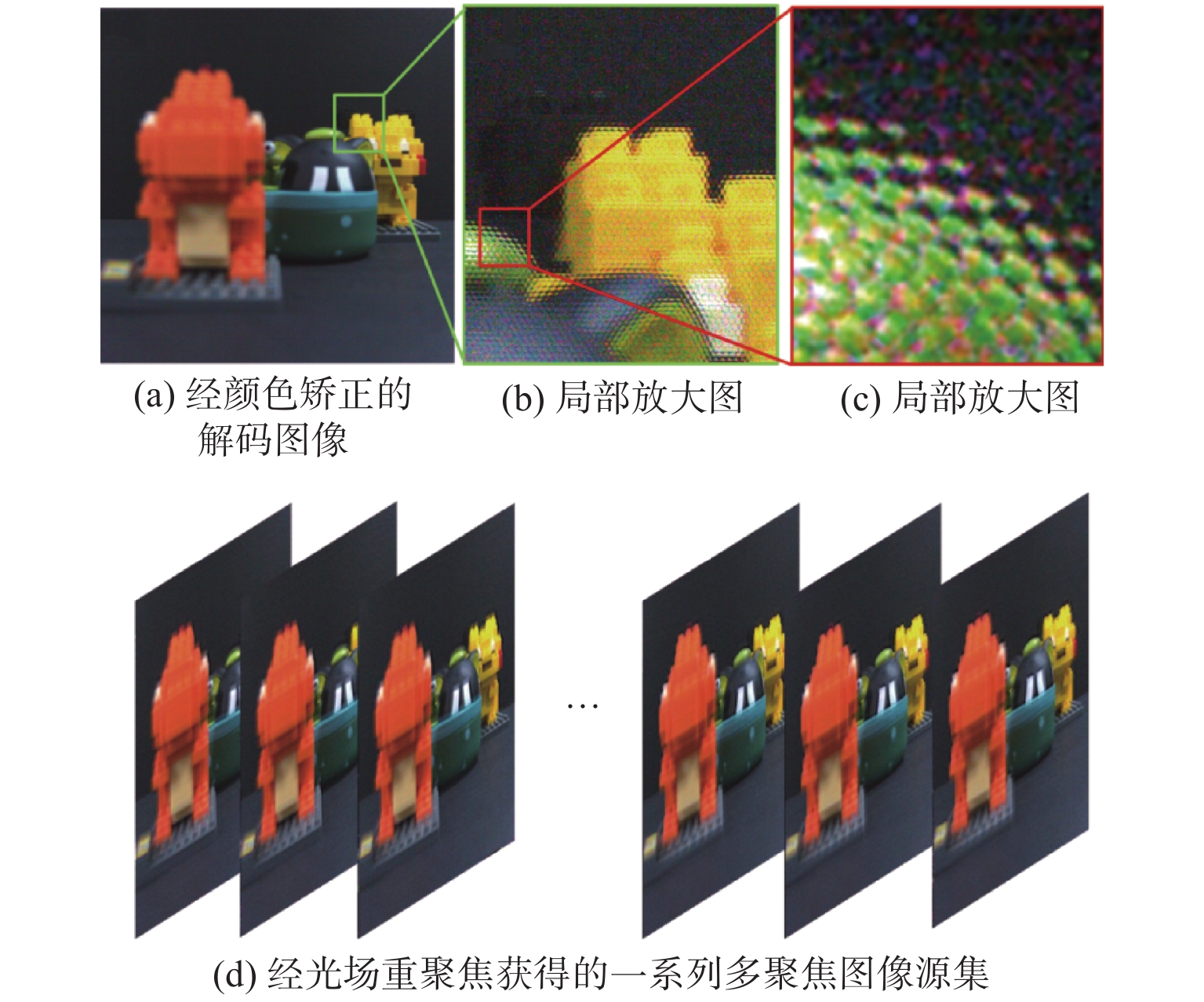

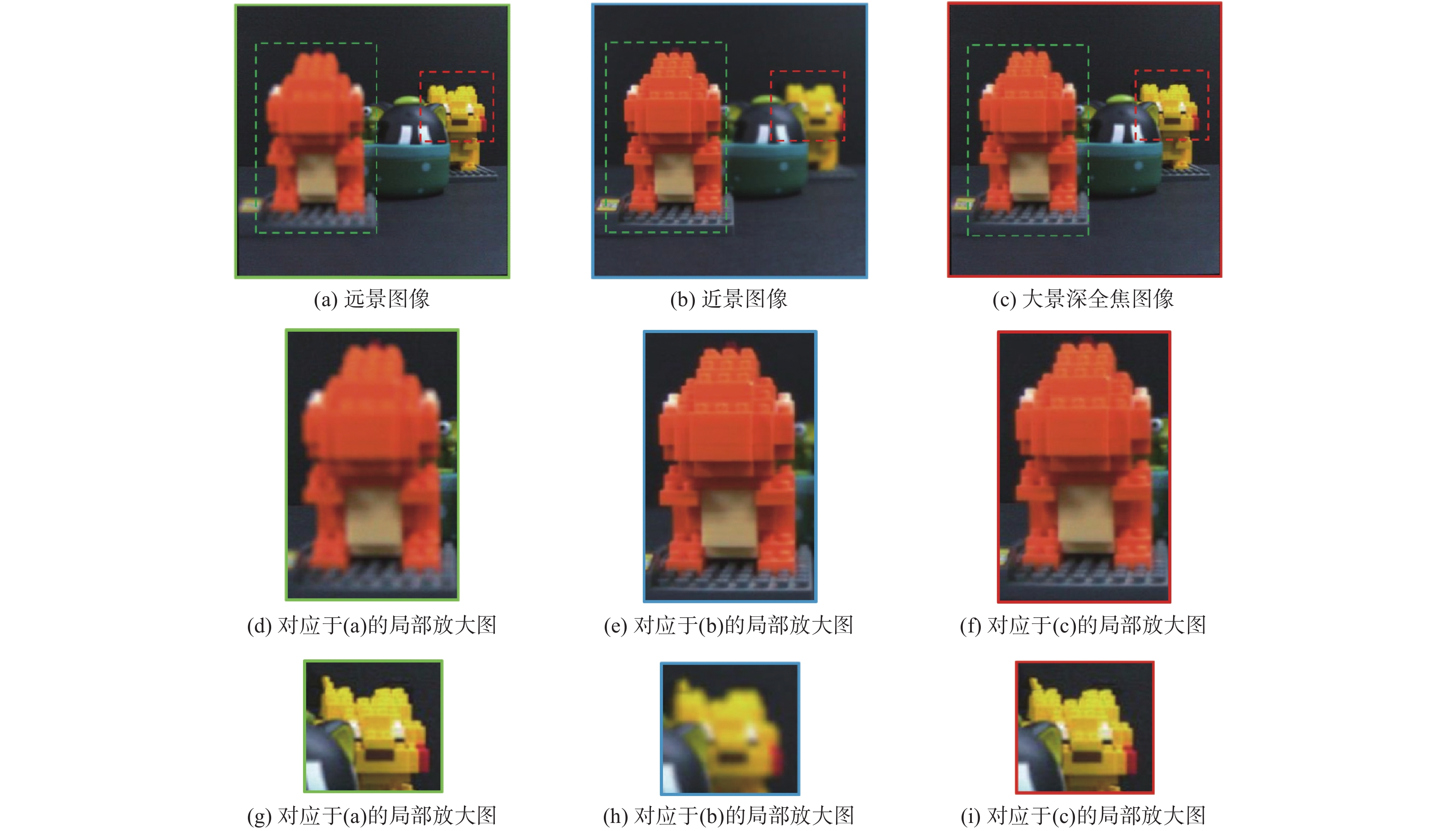

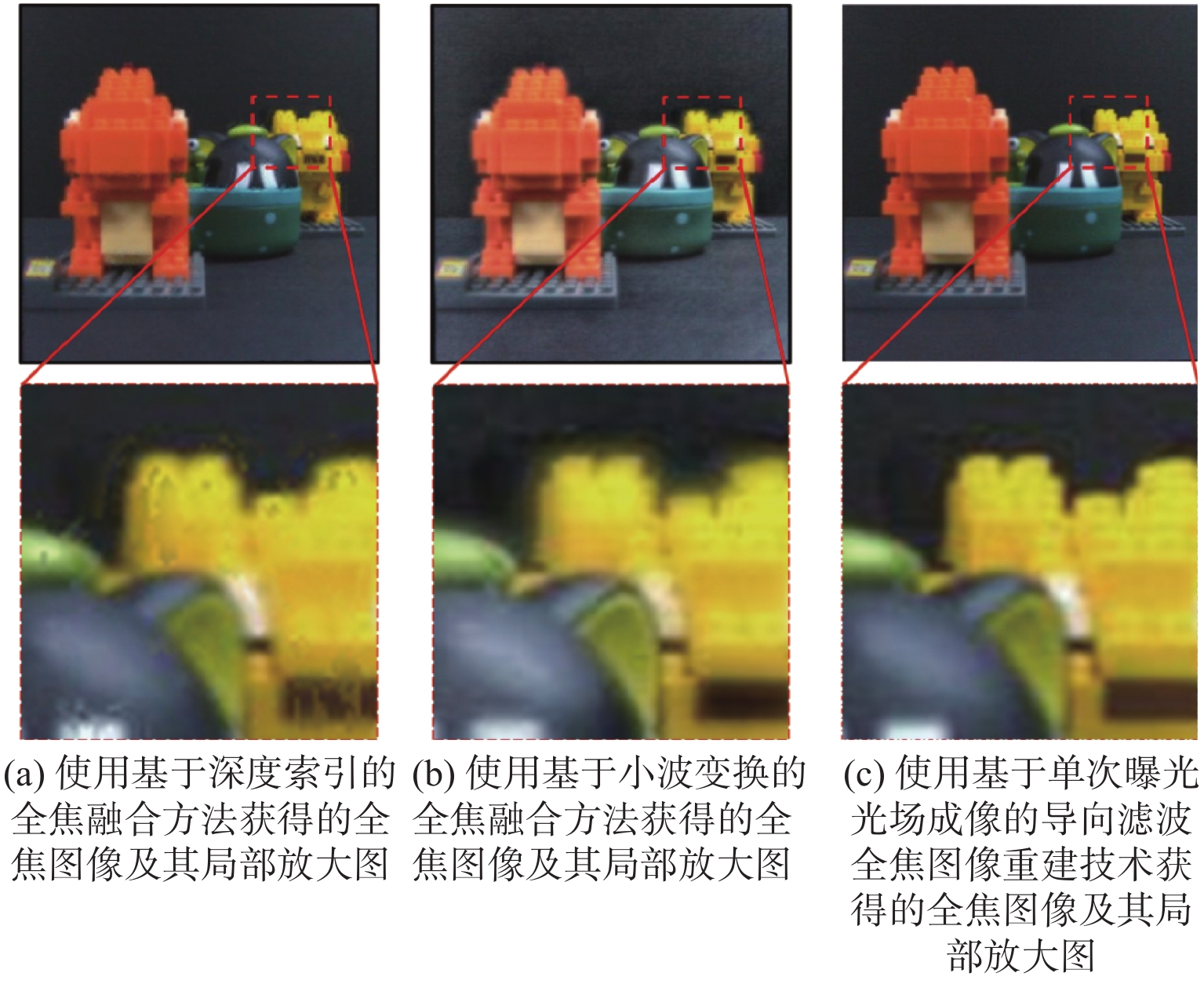

摘要: 为了实现大景深信息全焦面高质量成像,提出了基于单次曝光光场成像的导向滤波全焦图像重建技术:结合光场成像采集视场信息,并采用光场重建的方式获取多聚焦图像源集,利用导向滤波的方法确定各级图像融合权重,进行图像融合得到大景深的全焦图像。实验证明,提出的基于单次曝光光场成像的导向滤波全焦图像重建技术不仅有效保证了多聚焦图像背景的一致性,同时还具有更好的边缘保持效果,从而获得了清晰度更高、综合成像质量更好的全焦图像,因此该技术有望用于现场监控、地理勘探、军事侦察以及无人驾驶等众多领域中。Abstract: In order to obtain the high quality all-in-focus imaging in large depth of view, an all-in-focus image reconstruction technology based on single exposure light field imaging and guided filter was proposed. First, the field of view information was collected by the optical field imaging, and the multi-focus image source set was obtained by the optical field reconstruction. Then the guided filter method was used to determine the weight of image fusion at all levels, and finally the image fusion was performed to obtain the all-in-focus image with extremely large depth of field. The experimental results show that the proposed method not only effectively ensures the background consistency, but also keeps the edge retention to reconstruct the all-in-focus image with high quality. Therefore, the proposed technology can be potentially adopted in many applications such as on-site monitoring, geographical exploration, military reconnaissance and unmanned technologies, etc.

-

引言

核电站燃料组件受水下工作环境、装配应力和热应力等因素的影响,在工作中产生局部变形等问题,因此,核电站水下核燃料棒的高精度检测与维护是其安全运行的重要保障[1]。由于水下检测条件恶劣,水下核燃料棒高精度三维测量面临着巨大的挑战。基于线激光扫描的单目视觉测量方法采用单目摄像机在被测物表面做左右方向的扫描运动,获取线激光条纹信息,通过提取激光条纹中心,将其转换为三维点云坐标,实现被测物尺寸的高精度测量。水下检测中的激光条纹照射质量、水下检测环境和待测物表面特性都会对摄像机采集的光条图像造成影响[2],从而给中心线的提取带来一系列问题。因此,如何精确快速地提取光条中心线,是保证整个检测系统测量精度的关键一步。

近年来,国内外学者提出了许多条纹中心提取方法[3-4],主要有几何法[5]、极值法[6]、骨架提取法[7]、高斯拟合法[8]、方向模板法[9]、灰度重心法[10]等。极值法运算速度快,但若光条出现多个极值,定位精度会明显降低;骨架提取法方法简单,但其精度受环境影响大。田庆国[11]提出基于轮廓线多边形提取方法,可快速定位光带横截面方向并进行中心提取;方向模板法稳定性较弱,中心提取效果一般,王泽浩[12]提出自适应方向模板法,提高了方向模板的提取稳定性;高世一[13]提出变边限高斯拟合提取激光条纹中心线法,可适应条纹宽度进行高斯拟合;吴家勇[14]针对灰度梯度特性,提出了梯度重心法,有效提取了光条中心;Steger[15]基于Hessian矩阵得到光条横截面上一阶导数零点位置,求得光条纹中心线的亚像素位置,其考虑了光条几何特性,定位精度高,但无法解决光条中心多极值的问题,且运算速度慢,无法满足实时测量需求;灰度重心法考虑了光条灰度特性,运算快,熊会元[16]提出应用灰度梯度计算光条法线方向,在法线方向上应用灰度重心法精确提取光条中心的方法,解决了被测物体表面曲率变化大的问题;程鑫[17]结合Hessian矩阵对光条的中心进行定位,利用高斯曲线准确拟合出激光条的中心。以上算法提高了光条中心提取的速度及鲁棒性,但对于提取水下高反光表面光条中心的问题未能很好解决。

基于上述分析,本文提出了一种反光表面条纹自适应中心提取算法,基于光条几何特性自适应修正高反光区域轮廓,结合图像灰度卷积处理方法自适应修正高反光区域灰度分布,经灰度重心法确定中心点的亚像素坐标,实现了水下核燃料棒表面激光条纹中心的高精度提取。该方法可以有效地减少水下噪声及核燃料棒反光影响,准确、快速地提取激光条纹中心,控制三维重建精度在0.2 mm以内,满足核燃料棒变形测量精度0.3 mm的需求。

1 水下核燃料棒线激光条纹图像分析

当激光器投影到物体表面,将形成一定宽度的激光条纹,其光强从条纹中心展开,满足高斯分布。其条纹截面灰度值分布曲线的表达式为

$$ G\left(x\right) = \dfrac{S}{\sqrt{2{\text{π}} \sigma }}·\exp\left[-\dfrac{{\left(d-\mu \right)}^{2}}{2{\sigma }^{2}}\right]$$ (1) 式中:S为灰度值的幅值;σ为标准差;μ为光条截面坐标;d为光条中心坐标。

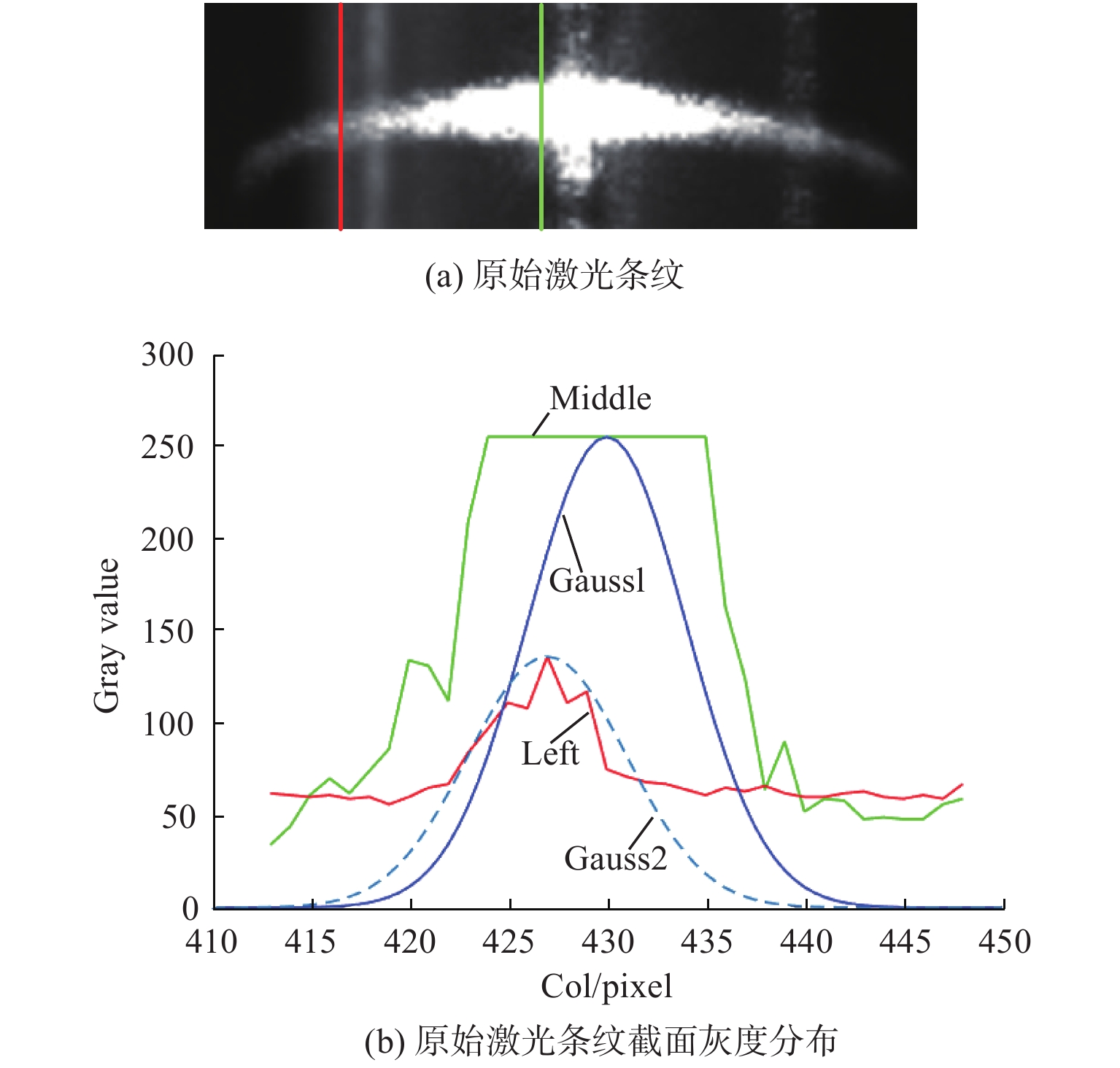

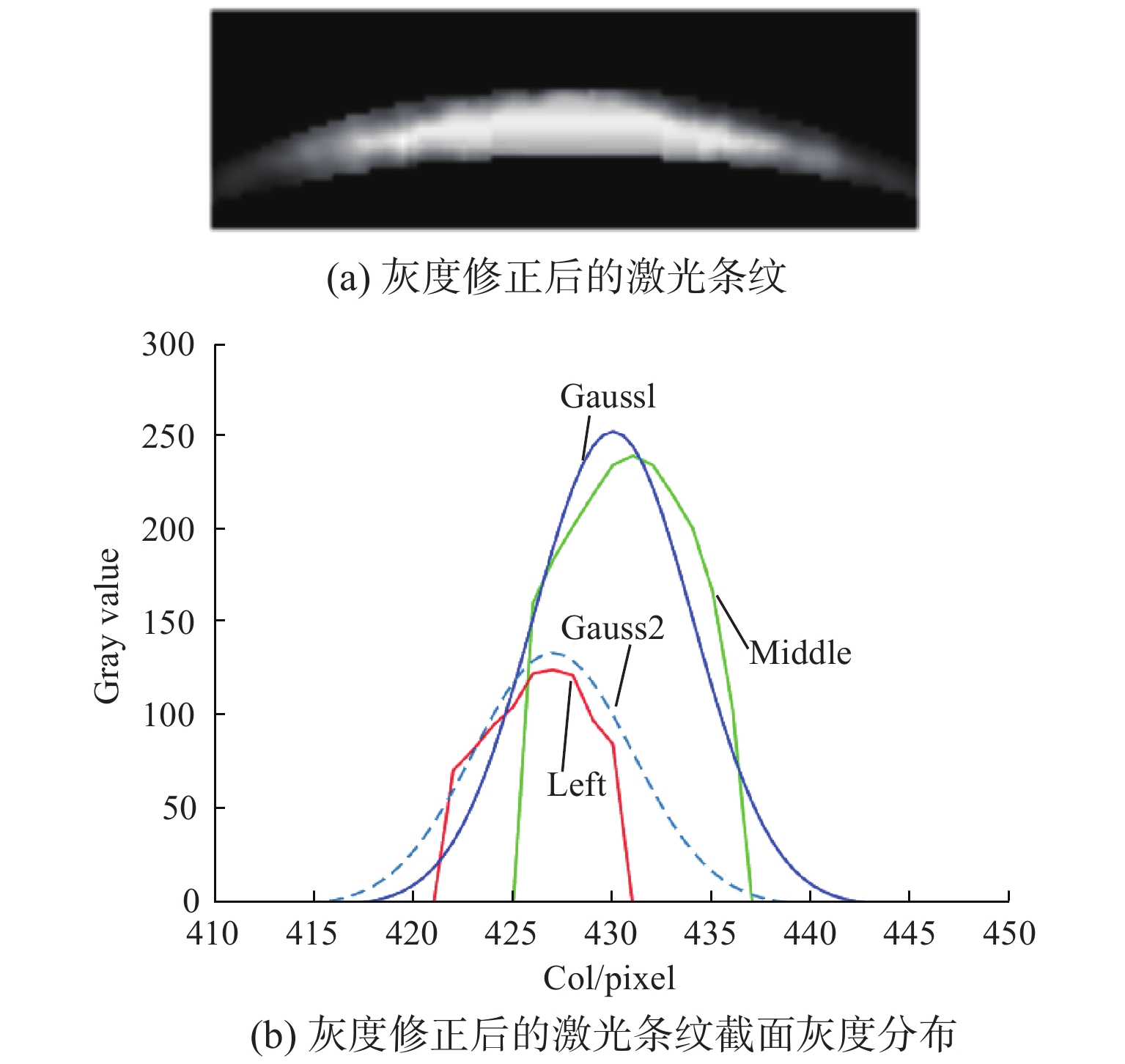

因激光器自身质量、测量环境及被测量物体材质的不同,单目摄像机所采集的激光条纹灰度分布差异性较大,为此,截取核燃料棒原始图像中激光条纹部分,绘制光条左部和中部截面的灰度分布曲线,见图1所示。

根据图1分析可以得到原始激光条纹图像具有以下特征:1) 光条边界附近存在水下环境噪声干扰;2) 光条截面灰度极值不同,截面宽度存在差异;3) 光条中间部分存在高反光区域,轮廓改变,灰度分布不满足近似高斯分布。

通过以上特征可以得到,受水下测量环境影响,获取的激光条纹图像存在大量噪声,影响激光条纹分离提取;受物体表面反光特性影响,光条中部截面处存在多灰度极值的情况,靠近光条中心灰度值迅速增加;受金属镜面反光特性影响,条纹中心出现垂直方向的反光噪点,通过调整图片曝光时间及拍摄角度可以减轻;通过传统提取中心算法难以获得精确激光条纹中心,中心线提取依赖光条中灰度分布符合高斯分布的截面信息。

文中出现较多物理量,主要分为3类。第1类是像素灰度值,其中ω表示像素点经预处理的灰度值;ω′表示像素点经自适应阈值提取的灰度值;ω″表示像素点经过灰度修正的灰度值。第2类是灰度分布,其中Tn表示灰度修正卷积模板;G(i,j)表示光条所在矩形内的点集。第3类是光条几何特征,其中wn表示激光条纹宽度;kv表示光条轮廓的切线方向;kn表示光条的截面方向。

2 激光条纹中心提取

2.1 图像去噪及光条初步提取

实际图像中因其他因素产生的噪声,需要通过图像去噪将其消除。通过对图像中噪声研究发现,水下核燃料图像中的噪声主要分为两种:一是孤立噪点或者由几个噪点组成的假光点;二是沿核燃料棒上下边缘的线状反光噪声。通过滤波方法及卷积运算消除噪声,保证对激光条纹区域提取的精确性。

1) 首先利用中值滤波处理图像,通过在噪点周围定义一个5×5的邻域窗口,对窗口中像素点灰度值进行升序排列,取灰度值的中值作为滤波结果,可以去除水下核燃料棒激光条纹图像中的椒盐噪点。

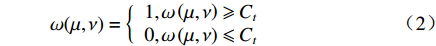

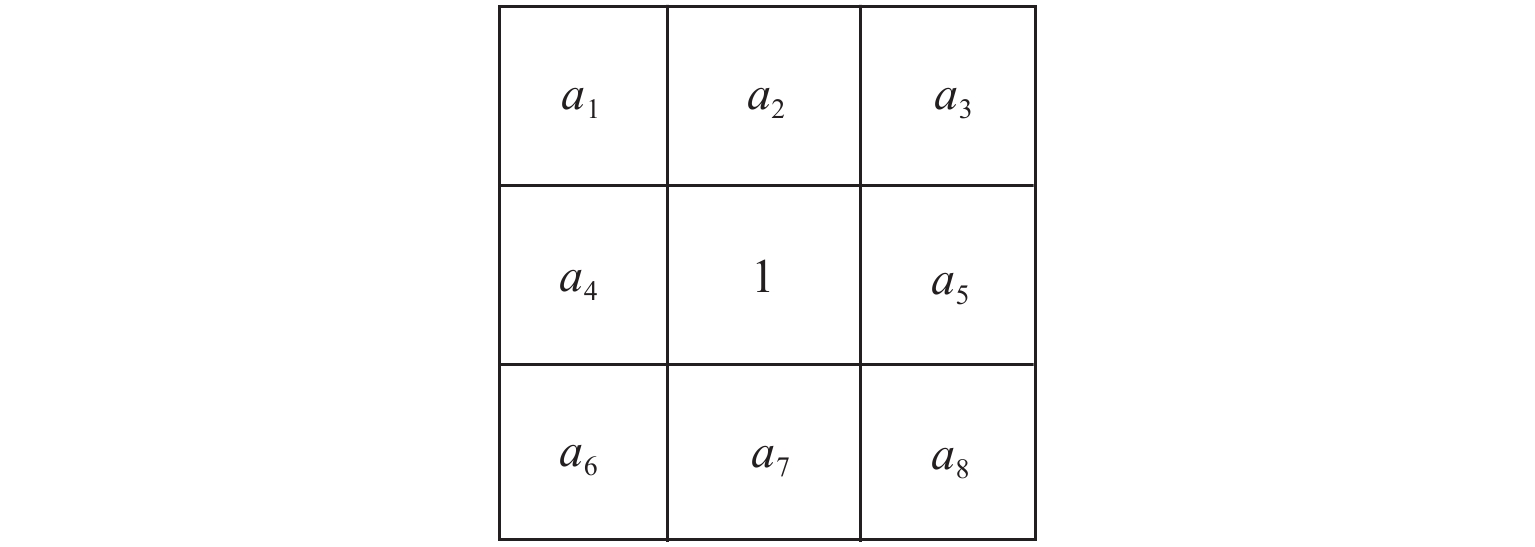

2) 对原始图像进行全局阈值的二值化处理,根据原始图像选择合适的灰度阈值Ct,计算实现图像二值化:

$$\omega (\mu ,\nu ) = \left\{ {\begin{array}{*{20}{c}} {1,\omega \left( {\mu ,\nu } \right) \geqslant {C_{{t}}}} \\ {0,\omega \left( {\mu ,\nu } \right) \leqslant {C_{{t}}}} \end{array}} \right.$$ (2) 式中ω(μ,ν)表示二值化后的光条在坐标(μ,ν)处的灰度值。

在灰度值非零的点上利用3×3模板去除噪点,模板如图2所示,a1~a8分别对应图像中的每个像素的位置。

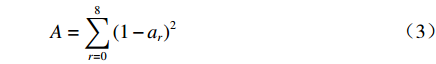

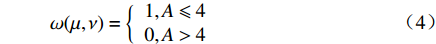

将该卷积模板在图像上移动,根据(3)式计算判定该点是否为噪点:

$$A = \sum\limits_{r = 0}^8 {{{\left( {1 - {a_r}} \right)}^2}} $$ (3) $$\omega (\mu ,\nu ) = \left\{ {\begin{array}{*{20}{c}} {1,A \leqslant 4} \\ {0,A > 4} \end{array}} \right.$$ (4) 通过对点(μ,ν)的A值进行判断,去除图像中的孤立噪点和沿核燃料棒上下边缘的反光噪点。将去噪图像与原始图像各像素灰度值相乘,获得具有原始灰度信息的去噪激光图像,最后使用高斯滤波平滑图像。

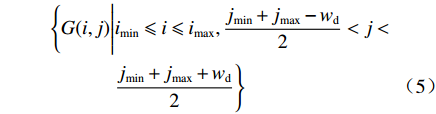

3) 根据图像灰度值,实现激光条纹的自适应阈值提取。从垂直激光平面方向开始扫描,寻找包含像素点的灰度值为255的行。当第一次检测到时,记该点为(imin,jmin),最后一次检测到时,记该点为(imax,jmax),框选出包含光条位置的矩形,矩阵宽度为wd。则光条所在的矩形内点集G(i,j)为

$$ \begin{split} \Bigg\{ G(i,j)\Bigg|& {i_{\min }} \leqslant i \leqslant {i_{\max }},\dfrac{{{j_{\min }} + {j_{\max }} - {w_{\rm{d}}}}}{2} <j < \\ & \dfrac{{{j_{\min }} + {j_{\max }} + {w_{\rm{d}}}}}{2} \Bigg\} \end{split} $$ (5) 根据每列像素灰度值对该光条截面的不同影响程度确定阈值,选择使用基于梯度的自适应行阈值法在矩形内计算每列的阈值。如图3所示,将激光条纹图像中任一列的灰度分布抽象为两条一次函数:

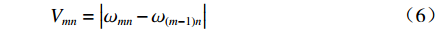

计算两像素点间灰度梯度Vmn:

$${V_{mn}} = \left| {{\omega _{mn}} - {\omega _{(m - 1)n}}} \right|$$ (6) 式中ω(m,n)是点(μ,ν)在图像第m行n列的灰度值。

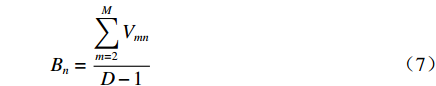

计算每行灰度梯度的平均值Bn:

$${B_n} = \dfrac{{\displaystyle\sum\limits_{m = 2}^M {{V_{mn}}} }}{{D - 1}}$$ (7) 式中D为光条大致宽度。

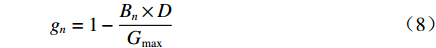

在进行测量时,D为25个像素。通过下式判断点(μ,ν)是否属于光条有效点:

$${g_n} = 1 - \dfrac{{{B_n} \times D}}{{{G_{\max }}}}$$ (8) $$ {\omega' }(\mu ,\nu )=\left\{\begin{array}{c}\omega (\mu ,\nu ),\omega (\mu ,\nu )\geqslant {g}_{n}·{G}_{\max}\\ 0,\omega (\mu ,\nu )<{g}_{n}·{G}_{\max}\end{array}\right.$$ (9) 式中:gn表示阈值界限系数;Gmax表示每行灰度的最大值;ω'(μ,ν)表示自适应阈值提取的光条在点(μ,ν)处的灰度值。

该方法能使光条的提取阈值根据列像素自适应变化,快速将激光从环境背景中提取,图4(a)为经自适应分割的光条图像。通过图4(b)分析,光条附近噪声被去除,提取出的光条图像边界明显,保证了提取精度。

2.2 光条轮廓修正

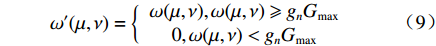

提取的光条已从图像背景分割,但由于反光现象,激光条纹在被测物体表面的轮廓发生改变,此时直接进行光条中心线提取无法达到精度要求。为解决这一问题,选取灰度分布满足高斯分布的光条截面端点,采用3层BP神经网络对所选坐标点进行曲线拟合,拟合出两条激光条纹轮廓,对光条进行进一步的修正提取。

如图5所示,BP神经网络设定输入层结点为X,隐藏层节点为h,输出层节点为Y,输入层和输出层节点数为1,隐藏层的节点数C为2。设定wic为输入层到隐层第c个节点之间的连接权值,ψc表示隐层第c个节点的阈值;woc为隐层第c个节点到输出层之间的连接权值,θ表示输出层节点的阈值;隐层输入变量为hic,c=1,2,隐层输出变量为hoc,c=1,2。

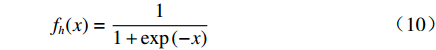

隐层激活函数fh选用(10)式Sigmoid函数,输出层激活函数fo则选用purelin函数。

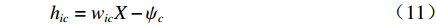

$${f_{{h}}}(x) = \dfrac{1}{{1 + \exp \left( { - x} \right)}}$$ (10) 隐层的第c个节点的输入为

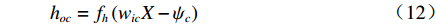

$${h_{ic}} = {w_{ic}}X - {\psi _c}$$ (11) 隐层的第c个节点的输出为

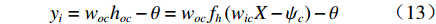

$${h_{oc}} = {f_{{h}}}\left( {{w_{ic}}X - {\psi _c}} \right)$$ (12) 输出层节点的输入为

$${y_i} = {w_{oc}}{h_{oc}} - \theta = {w_{oc}}{f_{{h}}}\left( {{w_{ic}}X - {\psi _c}} \right) - \theta $$ (13) 输出层节点的输出为

$${y_{{o}}} = {f_{{o}}}\left( {{y_i}} \right) = {f_{{o}}}\left[ {{w_{oc}}{f_{{h}}}\left( {{w_{ic}}X - {\psi _c}} \right) - \theta } \right]$$ (14) 设定Y(k)为第k个点的纵坐标,对图像中提取的总数为K的像素点拟合轮廓,在网络反向传播时神经网络得到的轮廓位置误差为

$${E^{\left( t \right)}} = \dfrac{1}{2}\sum\limits_{k = 1}^K {{{\left( {{y_{{o}}}^{\left( t \right)}\left( k \right) - Y\left( k \right)} \right)}^2}} $$ (15) 式中yo(t)(k)为神经网络权值在第t次调整后得到的第k个点的纵坐标。

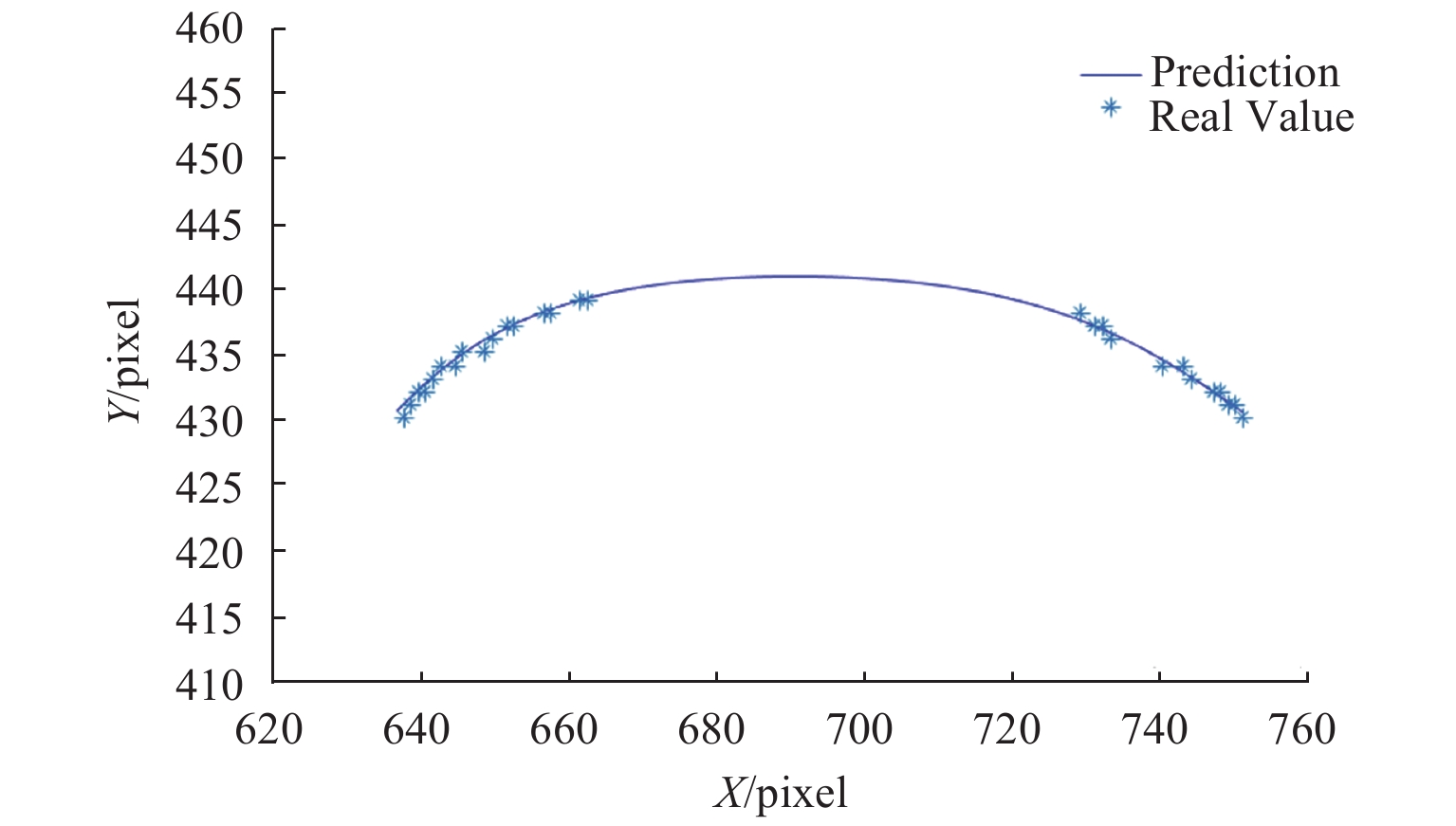

根据Levenberg-Marquardt最优化算法调整,得到最终神经网络权值。训练直到网络输出的误差减少到给定误差,或进行到预先设定的训练次数时,可以停止训练。设定目标误差为0.01,设定最大训练次数为1 000次,训练数据选取各行两端的非高反光区域像素坐标点,确定其为曲线轮廓拟合的真实值,基于条纹轮廓真实值进行预测,最终得到激光条纹的拟合曲线如图6所示。

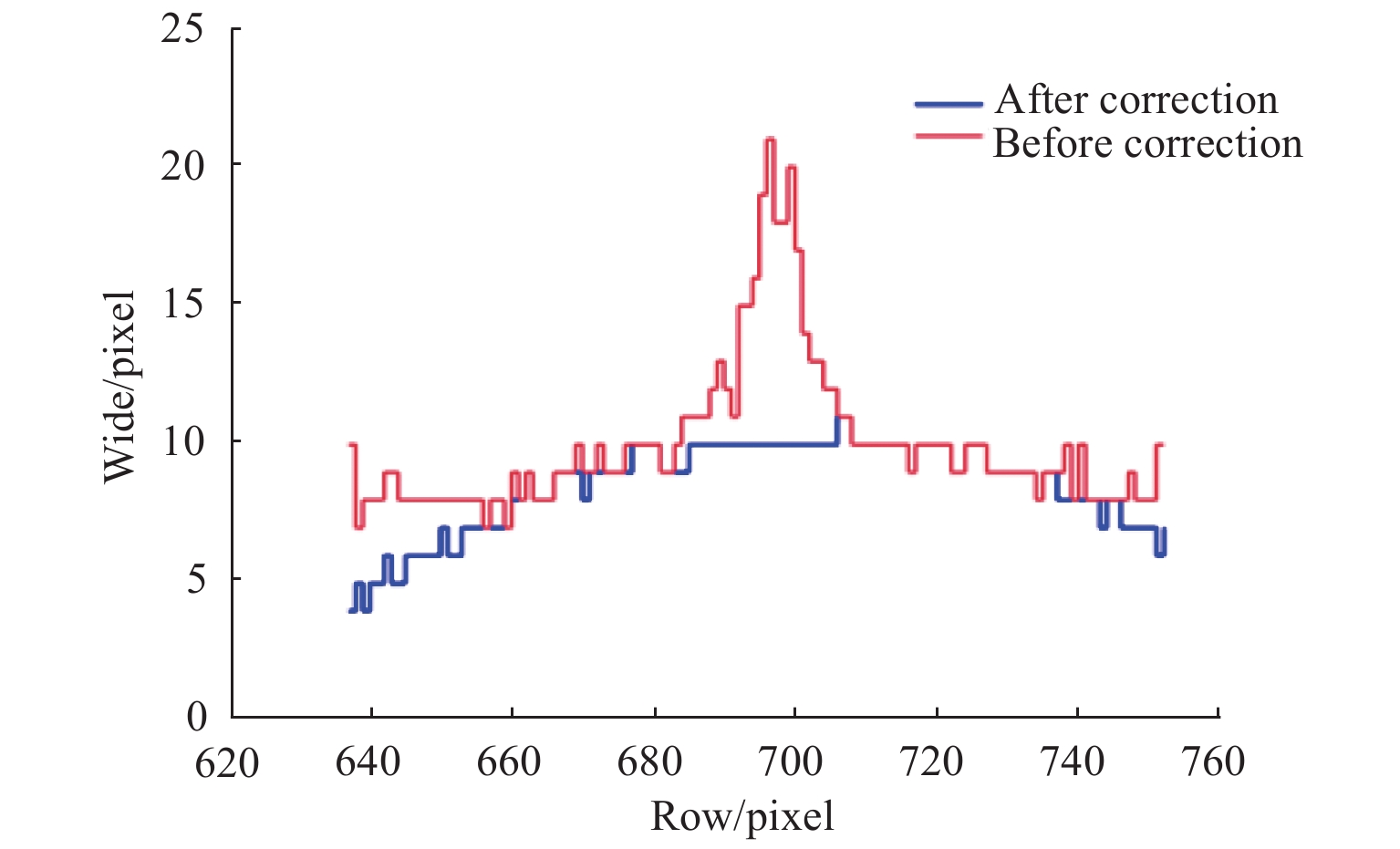

分别提取光条两边有效像素点进行轮廓拟合,可以获得经过轮廓修正的激光条纹图像,如图7所示。

如图8所示,两组数据分别为轮廓修正前后的激光条纹各行宽度,因反光干扰,修正前条纹各行宽度变化较大。通过BP神经网络对激光条纹的轮廓进行拟合,修正表面反光造成的光条宽度变化的部分,解决了激光条纹轮廓变形问题。

2.3 基于自适应卷积的灰度修正

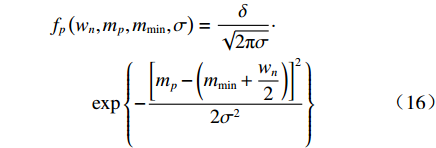

激光条纹反光部分轮廓已经修正,但各像素灰度值仍未改变。此时若对光条进行中心线提取,反光区域将存在多极值点的情况。本文方法通过设定自适应卷积模板修正光条灰度分布,利用条纹宽度信息生成模板对图像进行卷积运算,获得经灰度分布正常的激光条纹图像。因为线激光照射在被测物体表面后其灰度分布近似符合高斯分布,所以灰度修正系数将通过高斯函数设定。同一列中,像素修正系数由中部向列两边依次递减,激光条纹图像中任意一点p灰度修正系数表示为

$$\begin{split}& {f}_{p}\left({w}_{n},{m}_{p},{m}_{\min},\sigma \right) = \dfrac{\delta }{\sqrt{2{\text{π}} \sigma }}\cdot \\ &\quad\quad\exp\left\{-\dfrac{{\left[{m}_{p}-\left({m}_{\min}+\dfrac{{w}_{{n}}}{2}\right)\right]}^{2}}{2{\sigma }^{2}}\right\}\end{split}$$ (16) 式中:wn(n=0,1,…,N−1)为经过轮廓修正的激光条纹图像中点p所在第n列的非零灰度值像素个数,即光条带宽;N为含有非零灰度值的总列数,表示激光条纹长度;mp为点p所在行数;mmin为点p所在的n列中第1个非零像素点的行数;б为高斯函数标准差,取值为4;δ为固定系数,取值为0.95。

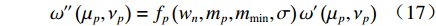

因为点p的灰度修正系数已经求得,所以激光条纹上的点p修正灰度值如(17)式所示:

$$ {\omega'' }\left({\mu }_{p},{\nu }_{p}\right)={f}_{p}\left({w}_{n},{m}_{p},{m}_{\min},\sigma \right)·{\omega '}\left({\mu }_{p},{\nu }_{p}\right)$$ (17) 式中:ω″(μp,νp)为点(μ,ν)经过灰度修正后的灰度值。

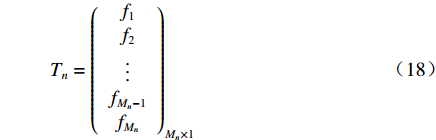

已知任意点的灰度修正系数后,可设计激光条纹图像中任意列的灰度修正卷积模板。卷积模板的行数设为激光条纹宽度wn,列数设为1,此时激光条纹的每个截面都可生成与其截面宽度相适应的灰度修正卷积模板Tn(n= 0,1,…,N−1)。由(16)式知fp的范围在(0~1)之内,且根据光条截面宽度wn,fp在模板中间时取最高值,然后依次向两边递减。激光条纹图像中任意列n的灰度修正卷积模板为

$${T_n} = {\left( \begin{array}{c} {f_1} \\ {f_2} \\ \vdots \\ {f_{{M_n} - 1}} \\ {f_{{M_n}}} \\ \end{array} \right)_{{M_n} \times 1}}$$ (18) 式中Mn为激光条纹第n列含有非零灰度值的总行数。

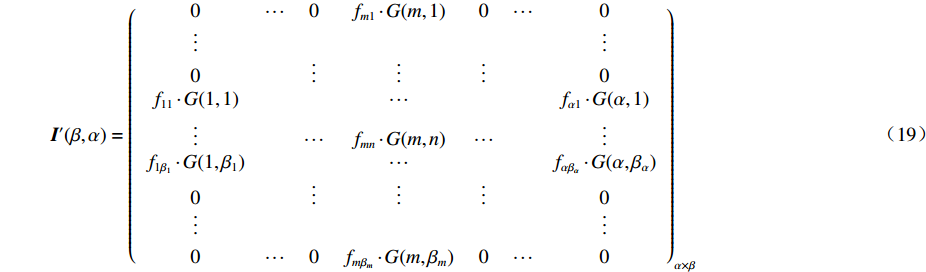

根据激光条纹宽度生成自适应灰度修正卷积模板,在光条原始灰度分布矩阵I(β,α)上自左向右进行滑动运算,可以得到激光光条修正后的灰度分布:

$$ {{I'}}(\beta ,\alpha ) = {\left( {\begin{array}{*{20}{c}} 0&\cdots& 0&{{f_{m1}} \cdot G(m,1)}&0&\cdots&0\\ \vdots& & & & & &\vdots \\ 0& &\vdots & \vdots & \vdots &&0\\ {{f_{11}} \cdot G(1,1)}&& & \cdots & & &{{f_{\alpha 1}} \cdot G(\alpha ,1)}\\ \vdots && \cdots &{{f_{mn}} \cdot G(m,n)}& \cdots && \vdots \\ {{f_{1{\beta _1}}} \cdot G(1,{\beta _1})}&& & \cdots & & &{{f_{\alpha {\beta _\alpha }}} \cdot G(\alpha ,{\beta _\alpha })}\\ 0&& \vdots & \vdots & \vdots&&0\\ \vdots& & & & && \vdots \\ 0&\cdots&0&{{f_{m{\beta _m}}} \cdot G(m,{\beta _m})}&0&\cdots&0 \end{array}} \right)_{\alpha \times \beta }} $$ (19) 式中:α为光条原始图像中含有非零灰度值的总列数;βm为第m列中含有非零灰度值的总行数,且1≤m≤α;β为激光条纹各列中含有非零灰度值总行数的最大值。

对经轮廓修正的水下核燃料棒扫描图像进行卷积灰度修正,其结果如图9(a)所示。

激光条纹反光部分灰度值过高,灰度分布改变,因此通过自适应卷积模板处理激光条纹图像灰度,对中间高反光区域进行灰度值降低使其满足高斯分布规律,如图9(b)所示,与图4(b)对比所见,获得了良好效果。

2.4 基于轮廓法线的光条中心提取

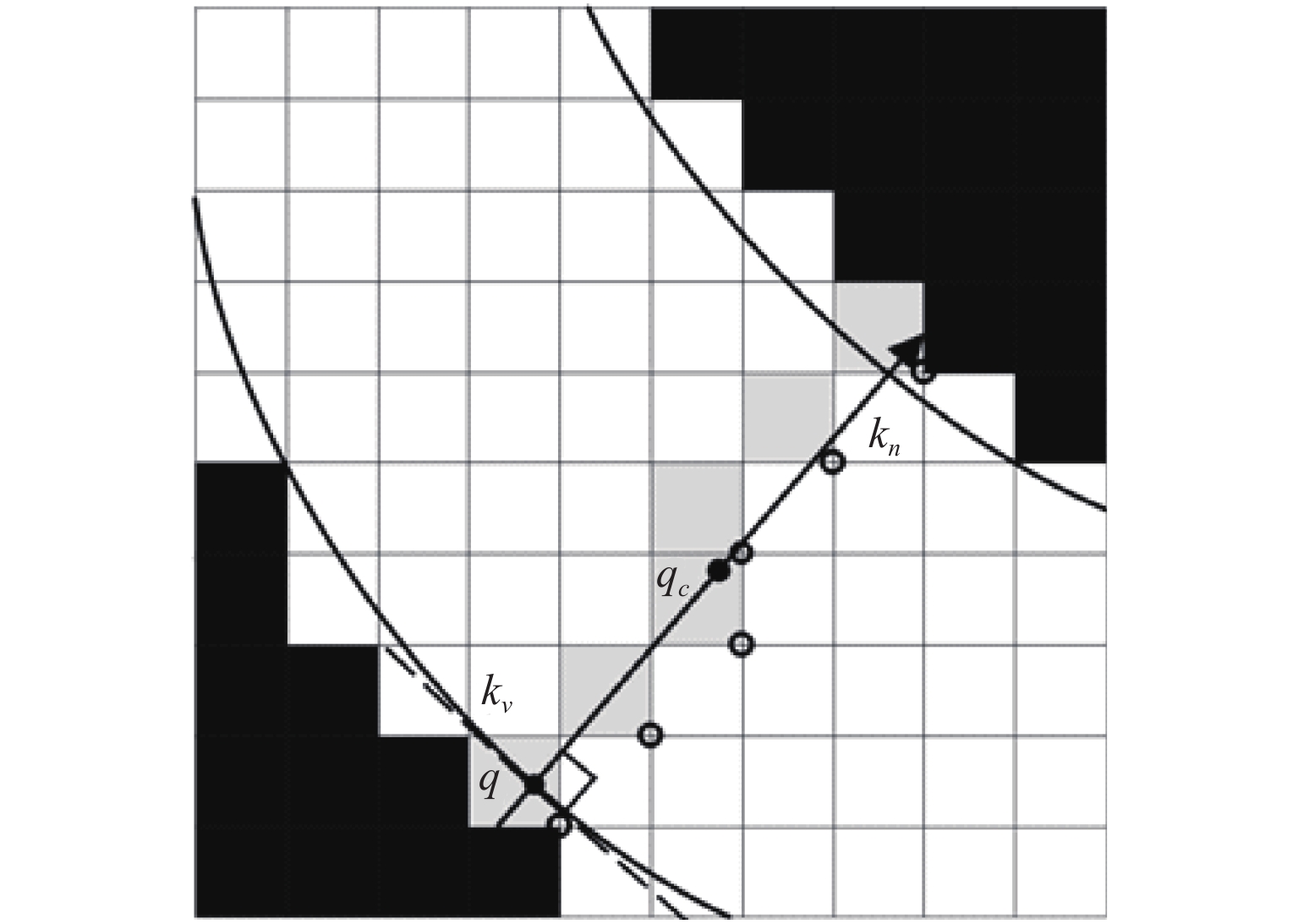

采用灰度重心法对完成修正的光条图像进行激光条纹亚像素中心提取。因为核燃料棒是圆柱体,所以线激光平面与核燃料棒表面相交形成的激光条纹轮廓通过单目摄像机采集后成曲线轮廓。对于非直线激光条纹的中心提取,需要在其光条截面方向进行。如图10所示,因为光条轮廓线已确定,所以可以通过计算其轮廓线上任一像素点的切线kv,确定光条的截面方向kn。

取轮廓线上一点为q,通过光条轮廓线在q点的一阶导数可求得该点在光条轮廓上的切线斜率kv。此时易得出经q点的光条截面方向斜率kn:

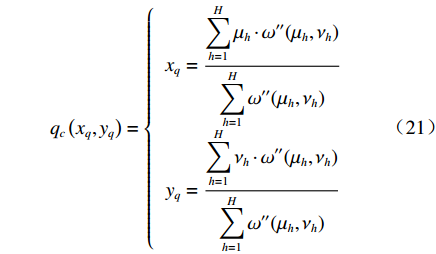

$${k_n} = - \dfrac{1}{{{k_v}}}$$ (20) 光条截面方向线条经过q点后向前后方向延长,直至抵达光条边界像素点,自适应光条宽度。通过判断像素点所在的行向量与列向量是否与斜率kn同时相交,确定其是否被光条截面方向线条经过。将符合条件的像素点记为一组像素点集合Xq={xh| xh=(μh,νh),h=1,2,…,H},其中H为光条截面方向斜率kn所经过的像素点总数。q点所在截面的亚像素中心通过在该像素点集合Xq内使用灰度重心法求解:

$$ {q_c}\left( {{x_q},{y_q}} \right) = \left\{ {\begin{array}{*{20}{c}} {{x_q} = \dfrac{{\displaystyle\sum\limits_{h = 1}^H {{\mu _h} \cdot \omega ''({\mu _h},{\nu _h})} }}{{\displaystyle\sum\limits_{h = 1}^H {\omega ''({\mu _h},{\nu _h})} }}}\\ {{y_q} = \dfrac{{\displaystyle\sum\limits_{h = 1}^H {{\nu _h} \cdot \omega ''({\mu _h},{\nu _h})} }}{{\displaystyle\sum\limits_{h = 1}^H {\omega ''({\mu _h},{\nu _h})} }}} \end{array}} \right. $$ (21) 式中:xq为q点所在光条截面的亚像素中心横坐标;yq为纵坐标。

3 实验及结果分析

采用Visio studio 2013作为软件开发平台、结合OpenCV 3.0库及PCL 1.8.0点云库实现文中方法。如图11所示,采用的水下核燃料棒线结构光测量平台,搭载Mako G-507 PoE 工业相机,其分辨率为2 464(H)× 2 056(V)像素,像素尺寸为3.45 μm×3.45 μm;激光器波长为520 nm。通过经水下标定的水下核燃料棒测量系统对核燃料棒尺寸进行测量。

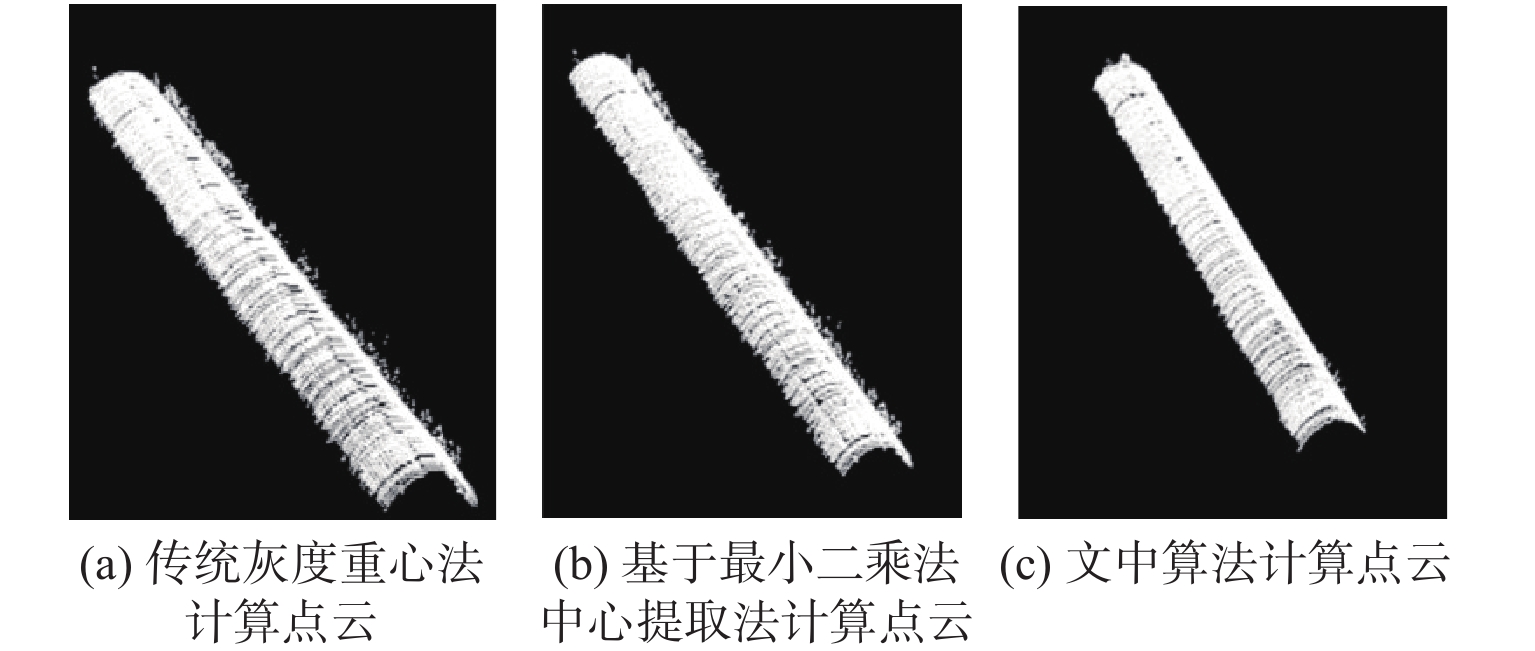

图12(a)~12(c)分别选用传统灰度重心法、基于最小二乘拟合中心提取算法[18]和文中算法进行激光条纹中心提取。从图12(a)可以看出,传统灰度重心法提取的光条中心线条受反光影响,光条中心点存在前后错开的现象,线条不连续;图12(b)中基于最小二乘拟合中心提取算法对光条进行提取,光条中心线条连续性增加,但由于其提取的中心点与拟合中心点重合不足,存在线条中心不唯一的情况,容易产生噪点;图12(c)为文中算法,算法充分利用了光条的有效数据,光条中心线条连续性较好,更客观地反映了光条中心分布情况。

使用3种算法提取激光条纹中心线后生成点云进行对比。图13(a)点云为传统灰度重心法生成,图13(b)点云为基于最小二乘拟合中心提取算法生成,图13(c)点云为文中算法生成。结构光中心线提取不准确,将导致通过图像坐标点求解出的三维坐标发生较大偏差,产生点云离群现象。可以看出,通过传统灰度重心法和基于最小二乘拟合中心提取算法得到的点云含有较多的离群噪点,被测物体各部分的反光导致多数截面光条中心线条出现断点和噪点,这些会影响点云测量的准确性;通过文中算法解决因反光造成的结构光中心线提取不准的现象,可以明显看到所获得的点云大量噪点被消除,圆柱点云表面更加光滑。

通过对10组测量提取的激光条纹中心线生成的点云进行直径测量,与核燃料棒人工采用游标卡尺测量的结果进行比对。表1所示为10组拟合直径统计结果。针对水下核燃料棒检测要求,测量数据应保持高精度与稳定性,传统灰度重心法在水下测量中稳定性较好,但是其测量数据误差较大,基于最小二乘拟合中心提取算法的测量数据的最大误差和平均误差有所减少,但是其稳定性不足。文中算法相较于传统灰度重心法和基于最小二乘拟合中心提取算法平均误差明显降低,分别为97%和89%,测量稳定性分别提高9%和33%,测量效果良好,拟合圆柱的误差在0.2 mm以内。可以看出,文中提出的算法能够有效减少核燃料棒水下测量的噪声,具有较好的稳定性和精确性。

表 1 核燃料棒测量结果Table 1. Measurement results of nuclear fuel rodmm 方法 灰度重

心法基于最小二乘拟合

中心提取算法文中算法 测量值 9.397 9.443 9.528 9.381 9.482 9.822 9.731 9.544 9.636 9.489 9.763 9.732 9.478 9.761 9.548 9.618 9.632 9.586 9.582 9.887 9.736 9.721 9.464 9.622 9.491 9.834 9.612 9.510 9.552 9.841 最大误差 0.2890 0.2170 0.1710 平均误差 0.1302 0.0338 0.0037 标准差 0.1214 0.1633 0.1102 4 结论

针对水下核燃料棒检测过程中激光条纹受水下环境噪声及反光影响的问题,本文根据激光条纹特征提出了结合BP神经网络轮廓拟合与卷积运算的自适应激光条纹亚像素中心提取方法。文中算法通过对核燃料棒反光部分的几何特性与灰度特征进行自适应修正,实现了水下核燃料棒表面激光条纹中心线的高精度提取。实验证明,使用该方法实现了在水下测量650 mm处燃料棒尺寸误差控制在0.3 mm以内。与其他算法进行比较,平均误差分别降低97%和89%,稳定性分别提高9%和33%,验证了该算法测量的精确性和鲁棒性。文中算法对于核燃料棒尺寸的准确测量,保证核燃料组件安全运行具有重要意义。

-

表 1 全焦图像重建技术伪代码

Table 1 Pseudocode for all-in-focus image reconstruction technology

Algorithm All-in-focus Image Reconstruction Input:Multi-focus images(I1,I2,……,IN) Output:All-in-focus image Ifusion 1: for N=1 to N do 2: Low frequency map LN←faverage(IN) 3: Obtain the low frequency map HN by Eq.(3) 4: edge information EN←flaplacian(IN) 5: if Ei(i,j)=max{E1(i,j),E2(i,j),……,EN(i,j)} then 6: PN(i,j)=1. 7: else 8: PN(i,j)=0. 9: end 10: weight maps←fguide(IN,PN)by Eq.(6)and Eq.(7). 11: Normalize weight maps by Eq.(8). 12: end 13: All-in-focus image is reconstructed by Eq.(9) -

[1] WANG Z, MA Y, GU J. Multi-focus image fusion using PCNN[J]. Pattern Recognition,2010,43(6):2003-2016. doi: 10.1016/j.patcog.2010.01.011

[2] CHEN C Y, HWANG R C, CHEN Y J. A passive auto-focus camera control system[J]. Applied Soft Computing,2010,10(1):296-303. doi: 10.1016/j.asoc.2009.07.007

[3] TURKAR M, AMBATKAR N S. Wavelet based multi-focus image fusion[J]. IInternational Journal of Scientific Progress and Research,2016,24(3):2349-4689.

[4] MEHDI N, MOHAMMAD A, MEHDI K. Multi-focus image fusion for visual sensor networks in wavelet domain[C]//International Symposium on Artificial Intelligence and Signal Processing. Cham: Springer International Publishing, 2014: 23-31.

[5] TIAN J, CHEN L. Adaptive multi-focus image fusion using a wavelet-based statistical sharpness measure[J]. Signal Processing,2012,92(9):2137-2146. doi: 10.1016/j.sigpro.2012.01.027

[6] YANG B, ZHONG J, LI Y, et al. Multi-focus image fusion and super-resolution with convolutional neural network[J]. International Journal of Wavelets, Multiresolution and Information Processing,2017,15(4):1750037. doi: 10.1142/S0219691317500370

[7] AMIN-NAJI M, AGHAGOLZADEH A, EZOJI M. CNNs hard voting for multi-focus image fusion[J]. Journal of Ambient Intelligence and Humanized Computing,2020,11(4):1749-21.

[8] CHEN N, REN Z, LAM E Y. High-resolution Fourier hologram synthesis from photographic images through computing the light field[J]. Applied Optics,2016,55(7):1751-1756. doi: 10.1364/AO.55.001751

[9] LEVOY M, HANRAHAN P. Light field rendering[C]//Proceedings of the 23rd annual conference on Computer graphics and interactive techniques - SIGGRAPH '96. USA: ACM Press, 1996.

[10] ZHANG B, WANG C, LIU Y, et al. Reconstruction of 3D temperature profile of radiative participatory flame based on digital refocusing technique of light field camera[J]. International Journal of Photoenergy,2019,6342808:1-13.

[11] 王宇, 张旭, 屠大维. 基于频域的像素光场图像重聚焦算法[J]. 光学仪器, 2016, 38(2): 121-127. WANG Yu, ZHANG Xu, TU Dawei . Refocus of the pixel light field image in the frequency domain[J]. Optical Instruments , 38(2): 121-127.

[12] ZHU H, ZHANG Q, WANG Q, et al. 4D light field superpixel and segmentation[J]. IEEE Transactions on Image Processing,2020,29:85-99. doi: 10.1109/TIP.2019.2927330

[13] KOO J I, PARK S B. Speckle reduction with edge preservation in medical ultrasonic images using a homogeneous region growing mean filter (HRGMF)[J]. Ultrason Imaging,1991,13(3):211-237. doi: 10.1177/016173469101300301

[14] HAO S J, WANG M, HONG R C, et al. Spatially guided local Laplacian filter for nature image detail enhancement[J]. Multimedia Tools & Applications,2016,75(3):1529-1542.

[15] LAVANYA D N, BALAKRISHNA P, BABU S K, et al. Guided image filter using multi-exposure image fusion: a patch-wise approach[J]. International Journal of Research,2017,4(1):591-596.

[16] ITO K, XIONG K. Gaussian filters for nonlinear filtering problems[J]. IEEE Transactions on Automatic Control,2000,45(5):910-927. doi: 10.1109/9.855552

[17] MONSON J, WIRTHLIN M, HUTCHINGS B L. Optimization techniques for a high level synthesis implementation of the Sobel filter[C]//2013 International Conference on Reconfigurable Computing and FPGAs (ReConFig).USA: IEEE, 2013.

[18] JAMEEL A, GHAFOOR A, RIAZ M M. All in focus fusion using guided filter[J]. Multidimensional Systems and Signal Processing,2015,26(3):879-889. doi: 10.1007/s11045-014-0302-7

[19] LUGT A V. Signal detection by complex spatial filtering[J]. IEEE Transactions on Information Theory,1964,10(2):139-145. doi: 10.1109/TIT.1964.1053650

[20] RANGAPPA S, MATHARU R, PETZING J, et al. Establishing the performance of low-cost Lytro cameras for 3D coordinate geometry measurements[J]. Machine Vision and Applications, 2019(30):615–627.

[21] 朱锡芳, 吴峰. 基于小波阈值法和维纳滤波的稀疏孔径光学系统成像的恢复[J]. 应用光学,2007,28(5):526-530. ZHU Xifang , WU Feng. Imaging restoration for sparse aperture optical systems based on wavelet threshold and Wiener filtering[J]. Journal of Applied Optics,2007,28(5):526-530.

[22] 陈清江, 石小涵, 柴昱洲. 基于小波变换与卷积神经网络的图像去噪算法[J]. 应用光学,2020,41(2):288-295. CHEN Qingjiang, SHI Xiaohan, CHAI Yuzhou. Image denoising algorithm based on wavelet transform and convolutional neural network[J]. Journal of Applied Optics,2020,41(2):288-295.

[23] PEREZ NAVA F, LUKE J P. Simultaneous estimation of super-resolved depth and all-in-focus images from a plenoptic camera[C]//3DTV Conference on the True Vision-Capture, Transmission and Display of 3D Video. USA:IEEE, 2009.

[24] 那彦, 殷廷瑞, 杨万海. 基于成像原理的小波包变换多聚焦图像融合[J]. 应用光学,2004,25(2):51-54. NA Yan, YIN Tingrui, YANG Wanhai. Multifocus image fusion based on imaging mechanism[J]. Journal of Applied Optics,2004,25(2):51-54.

[25] 王健, 陈洪斌, 周国钟,等. 改进的Brenner图像清晰度评价算法[J]. 光子学报,2012,41(7):855-858. doi: 10.3788/gzxb20124107.855 WANG Jian, CHEN Hongbin, ZHOU Guozhong, et al. An improved Brenner algorithm for image definition criterion[J]. Acta Photonica Sinica,2012,41(7):855-858. doi: 10.3788/gzxb20124107.855

-

期刊类型引用(5)

1. 周晟刚. 通风机械仪表盘在复杂背景环境中视觉故障检测与定位研究. 计算机测量与控制. 2024(03): 106-111+145 .  百度学术

百度学术

2. 吴来新,王志. 基于机器学习的眼位测定仪视线跟踪误差自动复合补偿技术. 自动化与仪器仪表. 2024(10): 370-374 .  百度学术

百度学术

3. 洪祥,张海越,宋骐. 基于图像识别的AH36钢激光焊缝节点定位技术研究. 计算机测量与控制. 2023(11): 299-305+314 .  百度学术

百度学术

4. 付晓艳,白雪,魏博凝. 基于机器学习的物流自动分拣机器人定位精度检测算法. 自动化与仪器仪表. 2022(08): 245-248+252 .  百度学术

百度学术

5. 刘翰林,张荣福. PCB焊点及芯线端头识别. 光学仪器. 2022(05): 42-52 .  百度学术

百度学术

其他类型引用(3)

下载:

下载:

陕公网安备 61011302001501号

陕公网安备 61011302001501号